Ao longo de mais de duas décadas de mercado, NVIDIA e AMD lançaram placas de vídeo que marcaram época – para o bem e para o mal. Algumas viraram ícones por inovar em performance, eficiência ou recursos. Outras, como as seis desta lista que separamos, ficaram famosas pelo fiasco. Vamos a lista!

| Placa de Vídeo | Fabricante | Data de Lançamento |

|---|---|---|

| GeForce FX 5800 Ultra | NVIDIA | 2003 |

| GeForce GTX 480 | NVIDIA | 2010 |

| Radeon HD 2900 XT | ATI/AMD | 2007 |

| GeForce GT 1030 DDR4 | NVIDIA | 2018 |

| Radeon VII | AMD | 2019 |

| GeForce GTX 1630 | NVIDIA | 2022 |

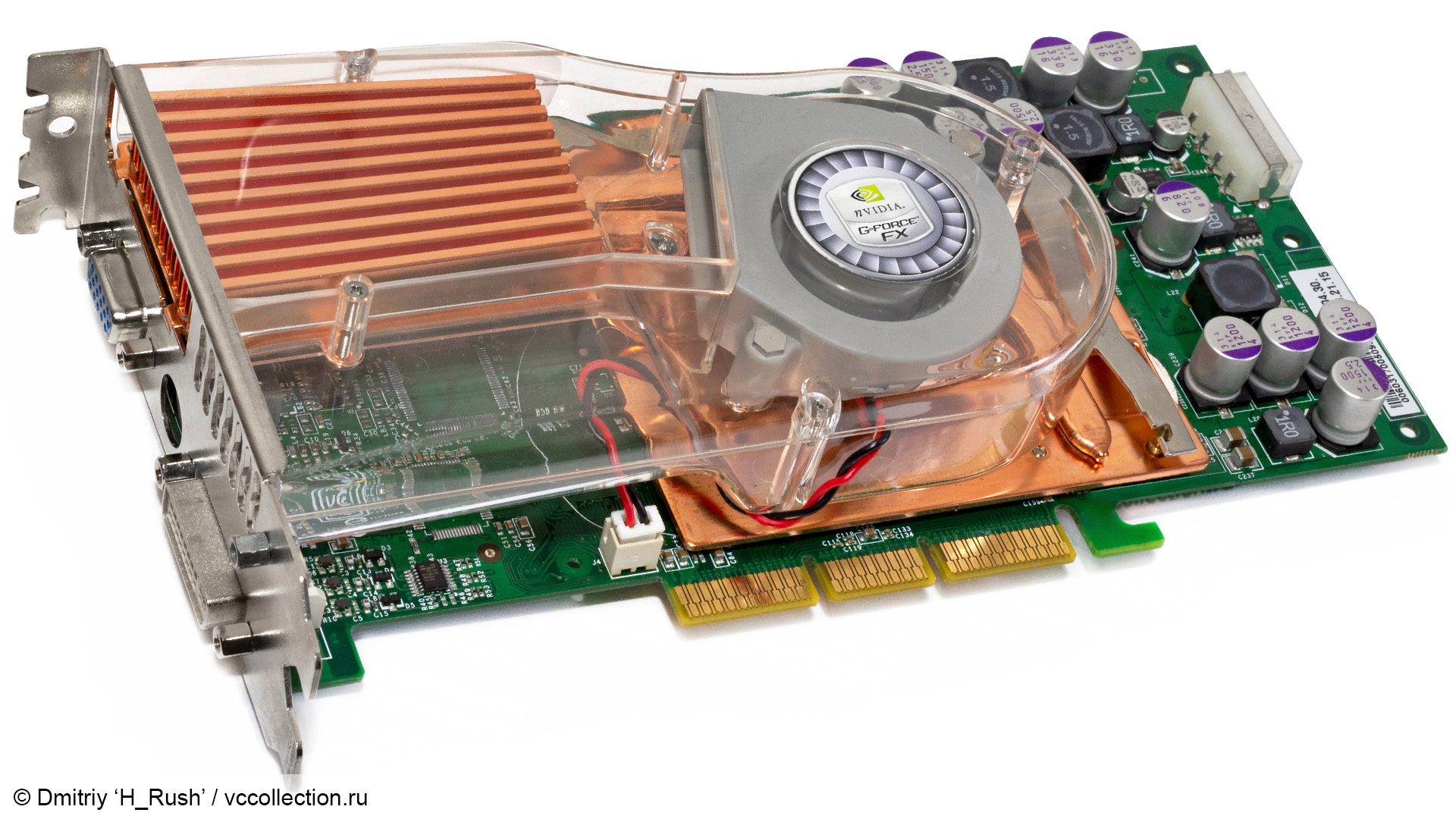

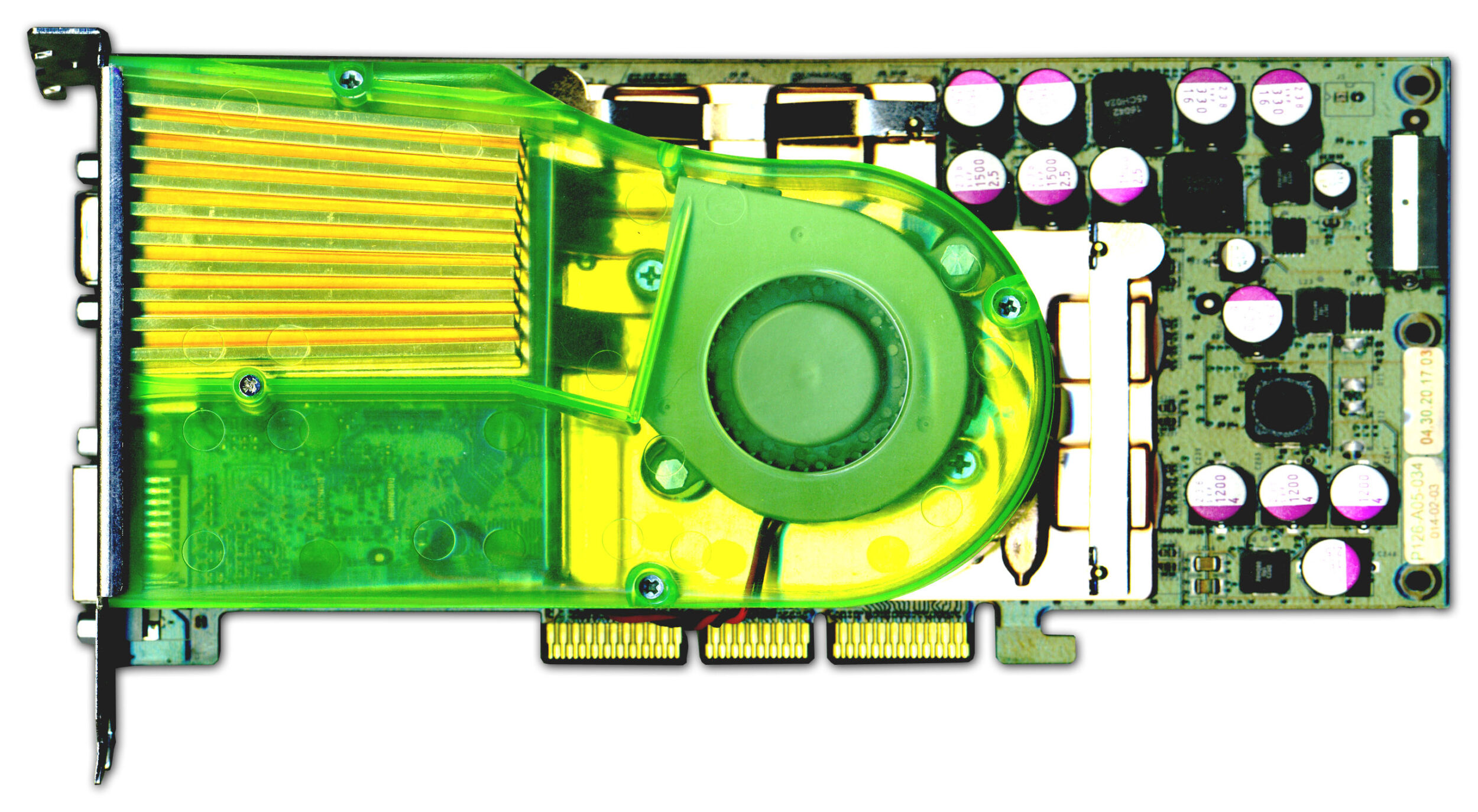

1. GeForce FX 5800 Ultra

Em novembro de 2002, a NVIDIA havia perdido a guerra de arquitetura. A ATI Radeon 9700 Pro, lançada em agosto do mesmo ano, havia chegado primeiro com suporte nativo a DirectX 9.0 e performance que deixava a GeForce4 Ti 4600 de NVIDIA bem para trás. O R300 (processo de 150nm) da ATI era tão avançado que a NVIDIA ainda nem tinha um competidor real.

A resposta de NVIDIA foi o NV30, primeira GPU da empresa com suporte direto a DirectX 9, e ela equiparia duas VGAS anunciadas em novembro der 2002: GeForce FX 5800 e 5800 Ultra.

E desde o início os problemas já surgiram. A NVIDIA simplesmente não conseguia fabricar. Meses se passaram sem que uma placa sequer chegasse ao mercado.

O NV30, com 125 milhões de transistores em processo de 130nm (menos avançado que o 150nm rival), precisava rodar em clock altíssimo (400 MHz na versão padrão, 500 MHz na Ultra), apenas para competir com a Radeon em largura de banda. Isso era 175 MHz acima do que a Radeon rodava. A memória também foi forçada ao limite: GDDR2 a 400 MHz (padrão) e 500 MHz (Ultra) em um barramento ridiculamente estreito de 128 bits.

Seis meses depois do anúncio, em abril de 2003, a Inno3D finalmente conseguiu colocar uma FX 5800 com NV30 nas mãos de reviewers.

O verdadeiro problema era o cooler. Era tão grande que ocupava dois slots, com um ventilador centrífugo que fazia barulho insuportável — ganhou apelidos como “Dustbuster” (aspirador) e “leaf blower” (soprador de folhas). Era impossível usar por mais de 30 minutos sem incômodo auditivo.

E a performance? Ficava 16% atrás em 3DMark 2003 e 12% mais lenta em Unreal Tournament 2003. O NV30 não escalava bem com DirectX 9, a nova API que deveria seu grande diferencial. A ironia era tanta que NVIDIA lançou um vídeo de marketing satirizando o próprio fracasso — com executivos discutindo como tornar a placa ainda mais barulhenta, alguém ventilando cabelo com ela, outro “assando uma salsicha” sobre o dissipador.

Em maio de 2003, apenas quatro meses depois, a NVIDIA lançou o NV35 (FX 5900 Ultra) com interface de memória dobrada e menos consumo, relegando a FX 5800 Ultra ao esquecimento.

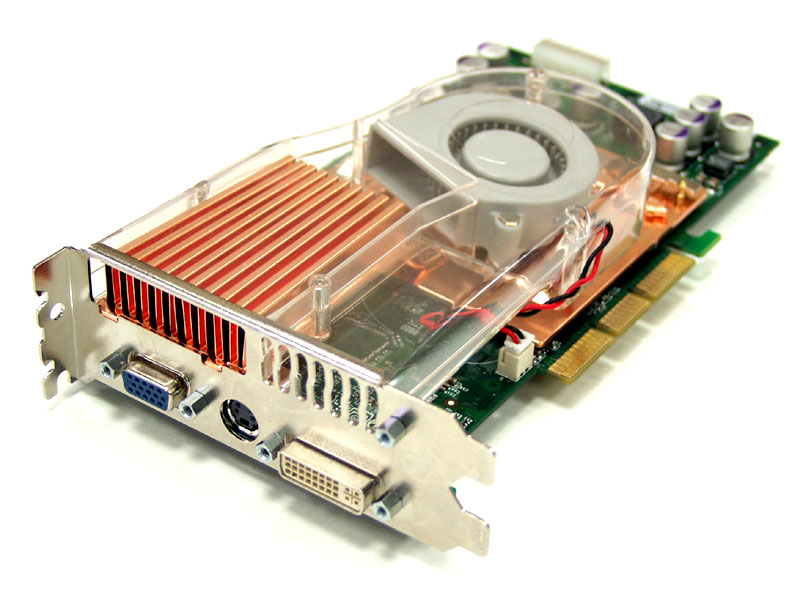

2. GeForce GTX 480

Quando o GTX 480 chegou em 2010, Nvidia finalmente havia recuperado a coroa de desempenho da ATI Radeon HD 5870. Mas o preço dessa vitória foi cobrado em watts, decibéis e graus Celsius.

O chip GF100 com 3 bilhões de transistores em processo de 40nm consumia 250W (em teoria), e na prática disparava para mais de 300W em carga. A Radeon HD 5870 consumia 200W. Para perspectiva: a NVIDIA cobrava US$480 enquanto a concorrente saía por US$380 — US$100 a mais por uma placa que precisava de dois conectores PCIe (6-pin + 8-pin) apenas para sobreviver.

O dissipador dual-slot com ventilador centrífugo mantinha temperaturas de 93°C sob carga — e isso com 68.5dB(A) de ruído. A placa foi apelidada de “The Furnace” (fornalha) e ganhou memes comparando-a com grelha de churrasco. Análises literalmente tentaram cozinhar ovos no dissipador (não conseguiram, mas quase).

A performance compensava minimamente: apenas 4-18% mais rápido que a Radeon HD 5870 em gaming real, dependendo do jogo. Para efeito de comparação, versus seu próprio antecessor (GTX 285), o ganho era decente, em torno de 50-64%. Mas AMD oferecia desempenho praticamente equivalente com menos barulho, menos calor e menos despesa com energia.

A Zotac tentou consertar o desastre. Sua GeForce GTX 480 AMP! substituiu o cooler NVIDIA por um modelo Zalman com dois ventiladores de 85mm, reduzindo o ruído de 68.5dB(A) para apenas 46dB(A). Temperaturas caíram de 93°C para 75°C. O problema era que custava $45 a mais e ocupava três slots PCIe. Provou uma coisa: o design de referência da NVIDIA era tão ruim que terceiros precisavam de coolers gigantescos para tornar a placa viável.

A NVIDIA reconheceu o fracasso rapidamente: em maio de 2010 lançou o GTX 580 com interface de memória dobrada e consumo reduzido. A GTX 480 foi descontinuada pouco depois.

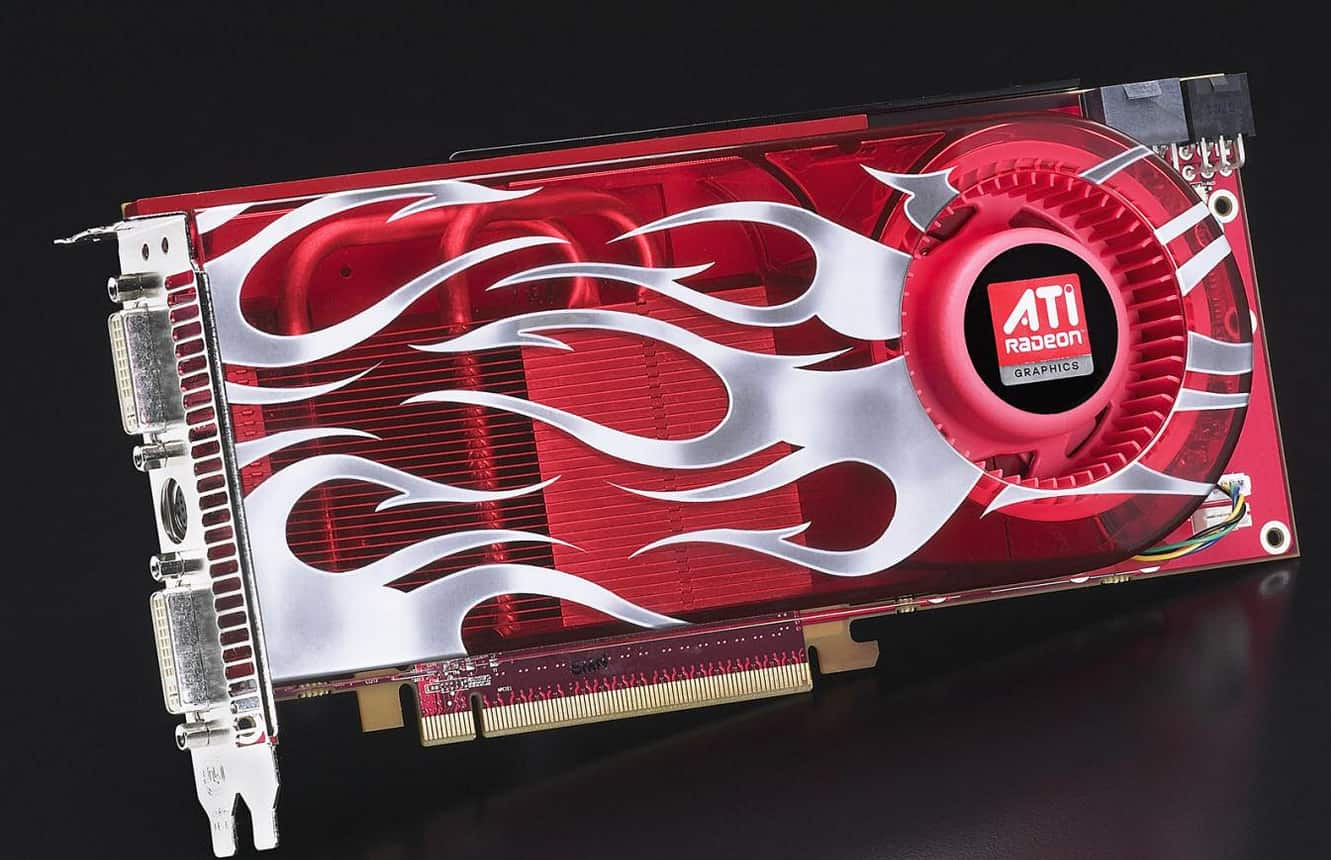

3. AMD Radeon HD 2900 XT

Quando o R600 finalmente chegou em maio de 2007, era a GPU mais esperado, e mais atrasada, da história da ATI. Anunciado em 2006, o lançamento havia sido adiado repetidas vezes. Meses se passaram enquanto NVIDIA consolidava domínio absoluto com a GeForce 8800 GTX e 8800 GTS. Quando finalmente saiu, era tarde demais.

O chip R600, que equipa a Radeon HD 2900 XT, era gigante: 700 milhões de transistores em processo de 80nm , com barramento de 512 bits e 106 GB/s de bandwidth no papel. Parecia impressionante. Mas a arquitetura unificada de shaders (primeira do tipo em ATI )tinha problemas graves. Sem filtro anti-aliasing ativo, a Radeon HD 2900 XT era 18% mais rápida que a 8800 GTS. Com AA ligado? Perdia 8% para a GTS. Contra a 8800 Ultra era catastrófico: 60-66% mais lenta com AA.

O design térmico era alarmante. A placa atingia 90°C sob carga com fan ao máximo. O Consumo de energia? 215W só do GPU, 400W total do sistema — 10% acima da 8800 Ultra, 20% acima da GTX. Exigia fonte de alimentação de no mínimo de 500W em um mercado onde 350W era padrão.

A Radeon HD 2900 XT virou símbolo retumbante de fracasso. Estava equipada com um chip que tinha potencial mas foi destruído por timing ruim, drivers incompletos e decisões de negócio desastradas. ATI melhoraria com o HD 3870, mas a ferida de 2007 nunca cicatrizou completamente.

Mas há uma coisa positiva, pelo menos na minha opinião. O design era espetacular. A inclui num artigo aqui do Hardware.com.br sobre 6 placas de vídeo bonitas e estilosas.

4. GeForce GT 1030 DDR4

Em 2018, NVIDIA fez algo bizarro: lançou duas versões completamente diferentes do GT 1030 sob o mesmo nome, com embalagem idêntica, preço praticamente igual, e nenhuma indicação clara de qual era qual.

A versão original usava memória GDDR5 de 6000 MHz com 48 GB/s de largura de banda. A nova versão? DDR4 a 2100 MHz com apenas 16.8 GB/s — uma redução de 65% em largura de banda.

Na prática, o desempenho era dividido pela metade. Em Fortnite a 1080p com configuração baixa, a versão GDDR5 rodava a 66 FPS, segundo testes do Compute Base. A DDR4? 33 FPS. Em Rocket League o desempenho caía ainda mais (gap até maior que 50%). A placa com chip DDR4 era frequentemente mais lento que Ryzen 3 2200G, CPU da AMD com chip gráfico embarcado.

O pior? A falta de transparência. A embalagem dizia apenas “GT 1030”. O preço era quase idêntico. Consumidores desavisados compravam achando que pegavam a versão que haviam visto em reviews, e descobriam em casa que rodavam Fortnite em 30 FPS ao invés de 60.

A NVIDIA nunca reconheceu publicamente. O produto foi silenciosamente descontinuado anos depois, como se a empresa quisesse varrer aquela vergonha para baixo do tapete.

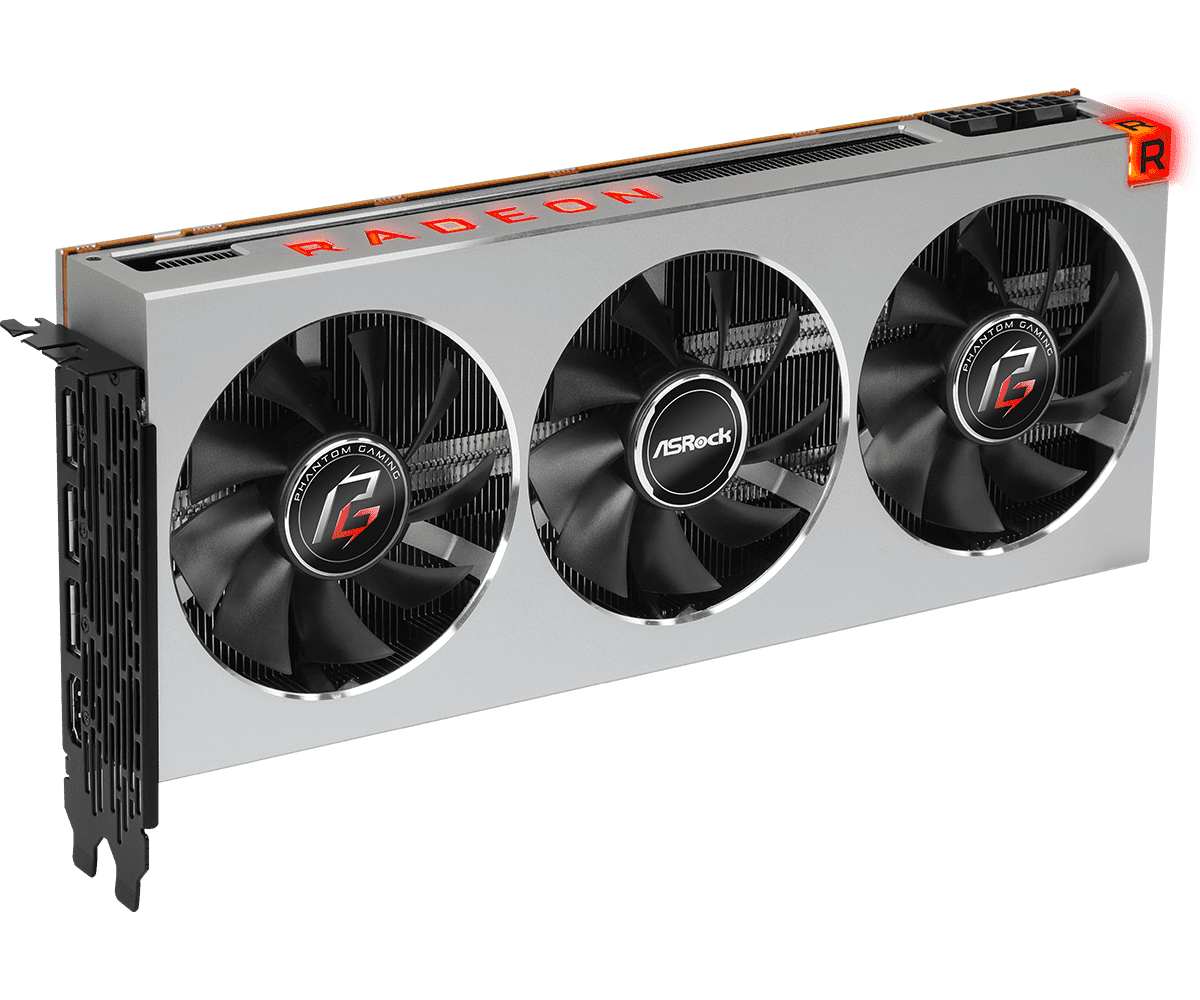

5. AMD Radeon VII

Em fevereiro de 2019, AMD chegou atrasado com uma placa que era basicamente uma VGA profissional em roupas de gamer.

Numericamente era impressionante no papel: 16GB de HBM2, interface de 4.096 bits, 1TB/s de largura de banda (o dobro da Vega 64). Arquitetura? Pura Vega reciclada, nada novo. AMD cortou 4 unidades de compute (ficando com 60 de 64) e compensou com clock mais alto (1.750 MHz vs 1.500 MHz da Vega 64).

Na prática, ficava 7-8% mais lenta que a RTX 2080 em gaming, que era o mesmo preço (US$ 699). Mas o verdadeiro desastre era técnico. A câmara de vapor não conseguia dissipar o calor adequadamente, atingindo 110°C sob carga, ponto onde a placa iniciava throttling (desaceleração automática). Quando reviewers reclamavam, AMD minimizou: ‘picos ocasionais acima de 110°C durante stress testing são considerados normais’ (exatamente a temperatura onde a placa começava a desacelerar).

Overclocking era um pesadelo, tentava-se aumentar clock e a performance piorava por instabilidade. Drivers de lançamento? Também foram um desastre completo, tinha problemas graves em todos os jogos desde o primeiro teste.

AMD basicamente apagou a Radeon VII de seu portfólio de marketing, a página de produto foi deletada do site, como se a empresa quisesse fingir que aquilo nunca existiu.

6.GeForce GTX 1630

A NVIDIA tinha um problema em 2022: a escassez de chips havia acabado, mas consumidores com orçamento apertado queriam uma placa barata. A resposta da empresa foi lançar GTX 1630 com preço sugerido de US$150 que ninguém conseguia encontrar por menos de $200.

A placa tinha 512 CUDA cores, interface de 64 bits, arquitetura Turing de 2019 reciclada. Basicamente um descarte de linha. O problema é que NVIDIA a colocou em um mercado onde o GTX 1050 Ti de 2016, seis anos mais velho, rodava frequentemente mais rápido ou empatava em muitos jogos. Um GPU de 2016 superava um lançamento de 2022.

A performance absoluta era ridícula: Cyberpunk 2077 a 1080p no baixo alcançava 30 FPS. Kingdom Come Deliverance 2 precisava 720p para ficar “jogável”. Red Dead Redemption 2 tinha drops constantes. Comparações com iGPUs atuais (Radeon 780M) mostravam que gráficos integrados frequentemente superavam o GTX 1630 em velocidade.

O verdadeiro crime era o preço. Se custasse US$ 70 (como o GT 1030 original em 2017), teria sido aceitável como placa de entrada, mas pelo preço que foi lançado era impossível defender. A NVIDIA lançou apenas para preencher um buraco no portfólio.